DataOps: cómo aplicar agilidad y automatización en la gestión de datos

Business analyticsEn un entorno donde la velocidad en la toma de decisiones es clave, DataOps se presenta como una metodología esencial para orquestar los procesos de datos de forma ágil, colaborativa y automatizada. A diferencia de los enfoques tradicionales, este modelo permite conectar a los equipos técnicos y de negocio en torno a pipelines de datos más eficientes, auditables y preparados para responder al cambio.

En este contexto, adquirir competencias en DataOps se convierte en una ventaja profesional estratégica. El Máster en Business Analytics e Inteligencia Artificial en Barcelona y Madrid de Inesdi permite dominar esta metodología con un enfoque práctico, aplicando principios de automatización, calidad y gobierno del dato. En este artículo, profundizaremos en qué es DataOps, cómo funciona, sus beneficios, herramientas y su relación con otras metodologías clave como DevOps y BI.

¿Qué es DataOps y de dónde surge?

La necesidad de procesar y entregar datos de calidad de forma rápida y segura ha llevado al nacimiento de nuevas metodologías que integren agilidad y automatización. DataOps surge como una respuesta a esta necesidad, tomando inspiración directa de la cultura DevOps, pero orientada al mundo de los datos.

Orígenes y definición: DataOps como DevOps para datos

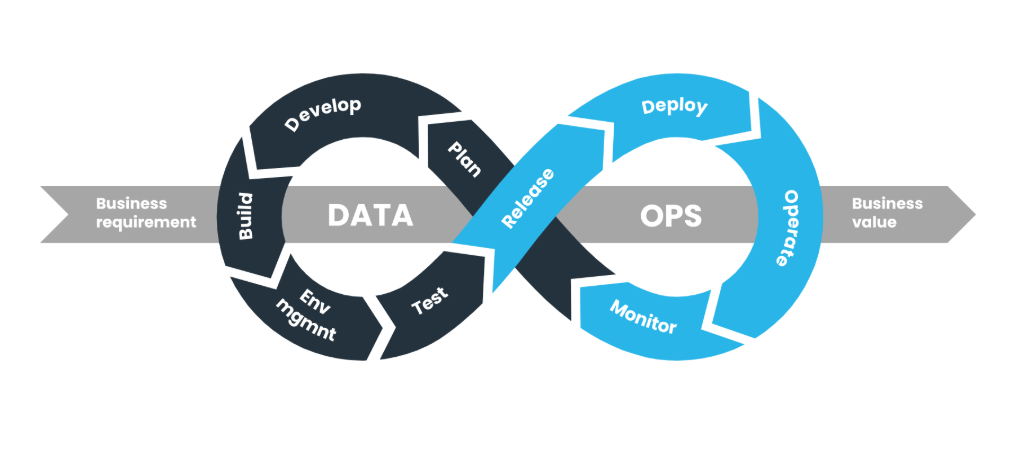

DataOps combina principios de desarrollo ágil, automatización y colaboración para mejorar la entrega de valor a partir de los datos. Tal como DevOps transformó la entrega de software, DataOps y DevOps comparten el objetivo de acelerar procesos sin perder control ni calidad. En este caso, se enfoca en todo el ciclo de vida de los datos: desde su ingestión hasta su uso analítico.

Esta metodología DataOps promueve flujos de trabajo colaborativos, automatizados y repetibles, permitiendo a los equipos técnicos responder a las demandas del negocio con mayor velocidad y precisión. Para conocer los fundamentos que sustentan este enfoque, es recomendable revisar Metodología DevOps: qué es y en qué consiste.

Comparativa ágil: DataOps vs gestión tradicional de datos

Frente a los enfoques tradicionales, que suelen estar marcados por procesos manuales y desconexión entre equipos, DataOps plantea un modelo mucho más dinámico, automatizado y colaborativo. Esta diferencia se resume en la siguiente tabla:

|

Gestión tradicional de datos |

DataOps |

|

Procesos manuales |

Automatización de pipelines de datos |

|

Silos entre equipos |

Colaboración multidisciplinar |

|

Baja adaptabilidad |

Iteración continua y mejora ágil |

|

Lenta respuesta al negocio |

Agilidad frente a cambios |

Principios fundamentales de DataOps

DataOps se apoya en un conjunto de principios que permiten transformar cómo se gestionan y entregan los datos. Estos principios combinan automatización tecnológica con una profunda cultura de colaboración y control, dando lugar a entornos de trabajo más ágiles y confiables.

Colaboración entre equipos (datos, IT, negocio)

Uno de los principales retos en la gestión de datos es la desconexión entre los equipos que los generan, transforman y consumen. DataOps propone eliminar estos silos fomentando una colaboración constante entre analistas, ingenieros, responsables de negocio y perfiles IT.

Buenas prácticas para fomentar esta colaboración:

- Documentación compartida y accesible.

- Herramientas de comunicación ágil (Slack, Jira, Notion).

- Reuniones periódicas entre datos, IT y negocio.

- Uso de métricas comunes para medir el impacto de los datos.

Automatización y pipelines continuos

Automatizar los procesos de datos es esencial para lograr eficiencia y escalabilidad. En DataOps, los pipelines de datos automatizados permiten extraer, transformar y cargar datos (ETL) de forma continua y sin intervención manual.

Este enfoque acelera los ciclos de entrega, reduce errores y garantiza que la información llegue a los usuarios de negocio en el menor tiempo posible.

Control, trazabilidad y calidad de los datos

Un principio clave de DataOps es garantizar la calidad de los datos en todo momento. Para ello, se implementan mecanismos de supervisión y control que aseguran la trazabilidad desde el origen hasta el análisis.

Esto refuerza la gobernanza de datos con DataOps, permitiendo cumplir normativas, detectar errores a tiempo y asegurar la confiabilidad de los datos en procesos críticos.

Beneficios estratégicos de implementar DataOps

Adoptar DataOps va más allá de una mejora técnica: representa un cambio profundo en cómo una organización extrae valor de sus datos. Las ventajas impactan tanto en la operativa diaria como en la estrategia a largo plazo.

Reducción de tiempos en análisis de datos

Gracias a la automatización de pipelines, los datos llegan más rápido a quienes los necesitan. Esto reduce drásticamente el tiempo entre la necesidad de análisis y la obtención de insights, mejorando la eficiencia en proyectos de datos y facilitando una respuesta ágil al negocio.

Mayor fiabilidad y gobernanza en la información

Los datos versionados, auditados y validados permiten tomar decisiones con mayor confianza. Además, la trazabilidad total aporta un marco sólido de cumplimiento legal y transparencia, elementos clave para sectores regulados.

Recomendamos complementar esta lectura con Data Governance: el pilar estratégico para la analítica empresarial.

Agilidad frente a cambios del negocio

DataOps ofrece una estructura lo suficientemente flexible para adaptarse rápidamente a nuevas fuentes, requisitos o tecnologías. Esta agilidad facilita una ventaja competitiva sostenible en mercados cambiantes. Puedes ampliar contexto en el artículo Big Data: qué es.

¿Cómo implementar DataOps? Buenas prácticas y herramientas

Implementar DataOps requiere tanto un cambio cultural como la adopción de herramientas adecuadas. A continuación, repasamos algunas prácticas esenciales para poner en marcha esta metodología.

Automatización de pipelines ETL

Automatizar los procesos de ETL es uno de los primeros pasos. Herramientas como Airflow, Talend o Azure Data Factory permiten diseñar workflows automáticos, versionados y supervisados. Para más detalles técnicos, consulta ETL: qué es, procesos y herramientas.

Integración continua y control de versiones en datos

Al igual que en DevOps, la integración continua permite desplegar cambios rápidamente, mientras que el control de versiones asegura trazabilidad. Versionar datasets y automatizar pruebas de calidad evita errores en producción y permite auditar el historial completo de los datos.

Supervisión de calidad y seguridad en cada fase del flujo de datos

Es fundamental supervisar la calidad y seguridad de los datos en cada etapa. A continuación, resumimos las acciones recomendadas:

Tabla: Supervisión por fase del flujo de datos

|

Fase del flujo de datos |

Supervisión recomendada |

Herramientas o técnicas posibles |

|

Ingesta |

Validación de origen y formatos |

APIs seguras, validadores JSON/XML |

|

Transformación |

Control de calidad y reglas de negocio |

Testing de datos, data profiling |

|

Almacenamiento |

Cifrado y versionado |

Data lakes, bases de datos con versionado |

|

Consumo (dashboards, BI) |

Control de accesos y trazabilidad de uso |

Auditoría, control de permisos |

Enlaces con metodologías y disciplinas afines

DataOps se integra naturalmente con otras disciplinas clave del entorno digital, formando un ecosistema robusto para la gestión moderna del dato.

DevOps como base cultural

La filosofía DevOps, centrada en colaboración, automatización y mejora continua, es la raíz conceptual de DataOps. Adoptar esta cultura es esencial para lograr una implementación eficaz. Te recomendamos volver a revisar Metodología DevOps: qué es y en qué consiste.

Business intelligence y análisis en tiempo real

La automatización de pipelines impulsa la alimentación en tiempo real de herramientas de BI, mejorando la capacidad de respuesta. DataOps fortalece este flujo con datos más limpios, consistentes y oportunos.

Gobernanza de datos y transparencia operacional

Con DataOps, cada acceso, transformación y carga de datos queda registrada, lo que aporta una transparencia operacional que potencia la confianza y el cumplimiento regulatorio.

Fórmate en Business Analytics e IA con Inesdi para dominar DataOps

Dominar DataOps requiere formación especializada que combine visión técnica, estratégica y de negocio. En el Máster en Business Analytics e Inteligencia Artificial en Barcelona y Madrid, aprenderás a diseñar pipelines automatizados, aplicar control de calidad y liderar la transformación analítica en tu organización.

La metodología práctica de Inesdi, basada en casos reales y docencia activa, garantiza una formación orientada al mercado laboral actual y a las necesidades futuras de la analítica avanzada.

Conclusión final: DataOps, la metodología para liderar la gestión moderna del dato

DataOps representa una evolución natural en la forma en que las organizaciones gestionan sus datos. Su enfoque colaborativo, automatizado y centrado en la calidad permite responder a los retos actuales de velocidad, volumen y veracidad. Para quienes buscan liderar en el mundo del dato, esta metodología es una herramienta indispensable.